激活函数

activation function :将输入信号的总和转换为输出信号,作用就是决定如何激活输入信号的总和。

sigmoid func

h(x) = 1 / 1 + exp(-x)

阶跃函数

相当于感知机

def step_fun(x):

if X > 0:

return 1

else:

return 0

#np的类型

def step_fun(x):

y = x > 0

return y.astype(np.int)

ReLU函数

Rectified Linear Unit

def relu(X):

return np.maximum(0,x)nn重要概念

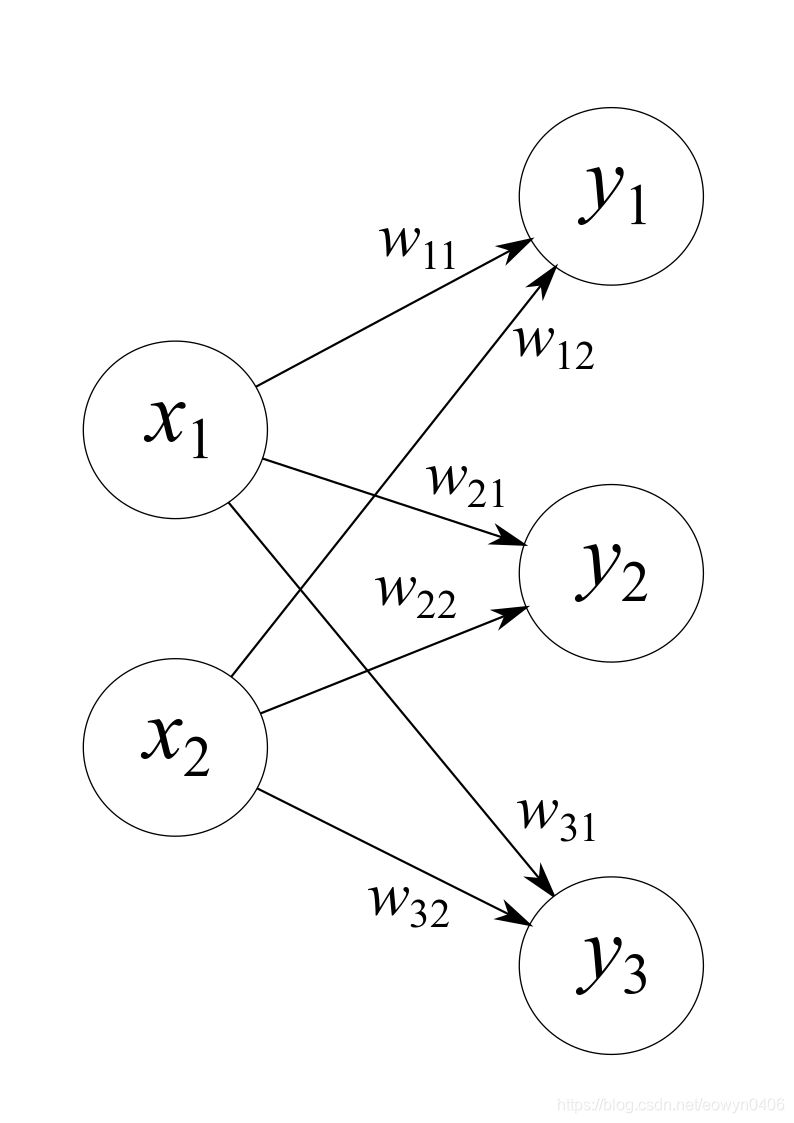

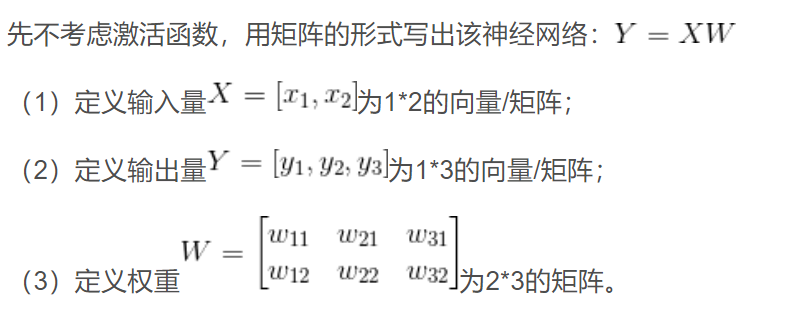

神经网络内积:

输出层: softmax():yk = exp (ak) / exp (a1+a2+…+an)